Redes sociais e IA: Por que a regulamentação é essencial para o Brasil

A regulamentação das IAs nas Redes Sociais faz parte do cenário digital. Os sistemas de inteligência artificial (IA) estão cada vez mais presentes em nossas vidas. Do conteúdo que consumimos aos debates públicos que moldam políticas, essas tecnologias passaram a desempenhar um papel fundamental. Mas o que acontece quando elas operam sem regulamentação? Governos ficam à mercê das big techs, gigantes do setor que, em muitos casos, já assumiram o papel de um “quarto poder”, influenciando sociedades e democracias sem prestar contas.

Exemplos de caos causado pela falta de regulamentação

Países como Myanmar mostram as consequências desastrosas da falta de controle. Em 2017, o Facebook foi acusado de ser usado para incitar violência contra a minoria Rohingya, com a disseminação de discursos de ódio que culminaram em genocídio. Por outro lado, na Índia, boatos espalhados pelo WhatsApp sobre sequestros de crianças levaram a linchamentos e mortes. Esses casos evidenciam como plataformas, sem supervisão adequada, podem amplificar o caos e a violência.

O papel do STF e do Congresso Nacional no Brasil

No Brasil, o Supremo Tribunal Federal (STF) tem adotado uma postura ativa no combate à desinformação, intensificando investigações sobre fake news e fortalecendo a responsabilização de indivíduos e grupos envolvidos. Paralelamente, o Congresso Nacional avança em discussões sobre projetos de lei para regulamentar redes sociais, com foco em transparência de algoritmos, moderação de conteúdos e maior responsabilidade das plataformas. Por fim, essas iniciativas representam passos importantes para conter os danos causados pela ausência de regulamentação.

Por que a regulamentação é crucial para países como o Brasil?

Em nações emergentes, como o Brasil, a falta de regulamentação das redes sociais e das tecnologias de IA traz riscos ainda maiores. O cenário é propício para a disseminação de fake news e manipulação de massas, agravado por desigualdades digitais e baixo letramento tecnológico. Campanhas de desinformação podem atingir eleições, políticas públicas e até a credibilidade das instituições.

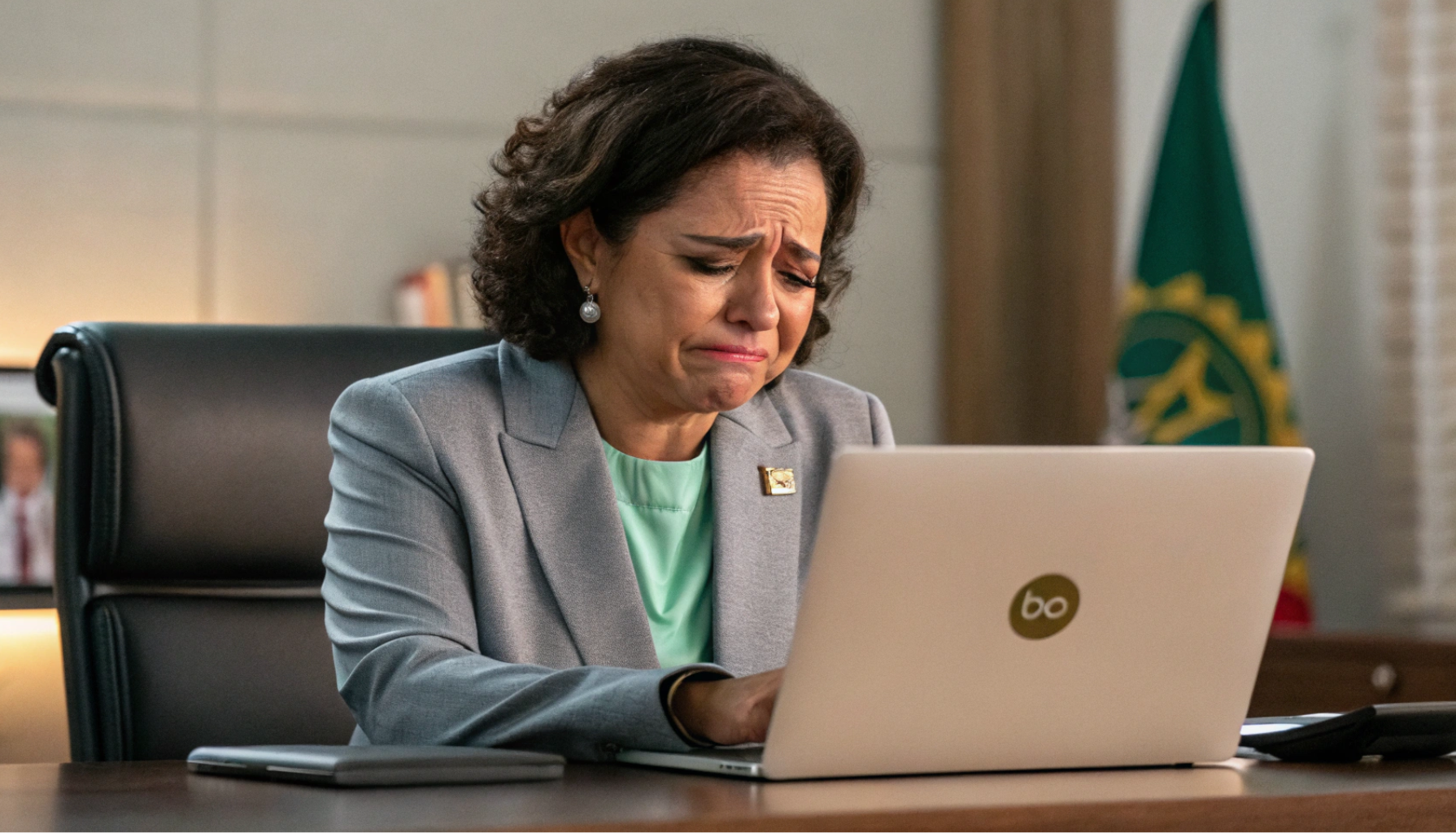

Além disso, as big techs operam com algoritmos que priorizam engajamento acima de tudo, sem distinção entre conteúdo verdadeiro ou falso. Prefeitos e gestores públicos enfrentam crises evitáveis por falta de moderação rigorosa.

Como funcionam os algoritmos e os sistemas de busca?

De forma simplificada:

- Algoritmos das redes sociais: Eles priorizam o que aparece no feed com base em engajamento, relevância e comportamento do usuário. Isso significa que quanto mais curtidas, comentários ou compartilhamentos um conteúdo recebe, mais ele é exibido para outras pessoas, independentemente de sua veracidade.

- Sistemas de busca nas plataformas: Baseiam-se em palavras-chave e histórico de pesquisa. O problema é que muitas vezes priorizam o que é popular, e não o que é correto ou confiável.

Prefeitos ainda não entendem o básico

Enquanto o mundo debate regulamentações complexas, muitas prefeituras brasileiras estão atrasadas no básico: Muitos prefeitos ainda não entendem como funcionam os algoritmos das redes sociais ou os mecanismos de busca. Como, então, podem enfrentar crises de desinformação? Essa falta de conhecimento técnico compromete não apenas a comunicação pública, mas também a capacidade de proteger a população de campanhas de desinformação localizadas.

Reclamar não é o suficiente – ação é necessária

Governos locais não podem esperar soluções prontas das big techs ou apenas se alarmar com as consequências da desinformação. Por fim, a regulamentação das IAs nas Redes Sociais é importante. Prefeitos e gestores públicos devem pressionar os governos federais e estaduais por regulamentações eficazes dessas plataformas. A criação de leis que exijam transparência, moderação responsável e auditoria de algoritmos é fundamental para garantir que as redes sociais sejam usadas de forma ética e segura.

A desinformação nas redes atinge a todos — inclusive as prefeituras — quando falta controle.